LEXIS Noticias

Ley de Inteligencia Artificial: aprobación del Parlamento Europeo

El 13 de marzo, el Parlamento Europeo ratificó la Ley de Inteligencia Artificial, dando un paso importante para su aprobación definitiva en la Unión Europea. Su aprobación se dio gracias a 523 votos a favor, 46 en contra y 49 abstenciones. Está previsto que la Unión Europea apruebe la norma durante las próximas semanas, la misma que entrará en vigor en etapas hasta su vigencia plena en 2026.

¿Cuál es el objetivo de la Ley?

La ley busca establecer requisitos y responsabilidades claros para los desarrolladores y usuarios de IA, al tiempo que busca aliviar las cargas administrativas y financieras, especialmente para las pequeñas y medianas empresas (PYME). Forma parte de un conjunto más amplio de medidas políticas destinadas a respaldar el desarrollo de una IA confiable, que incluye iniciativas de innovación y un plan coordinado. Estas acciones tienen como objetivo garantizar la seguridad y los derechos fundamentales tanto de individuos como de empresas en relación con la IA, promoviendo la adopción, inversión e innovación en toda la Unión Europea.

Este es el primer marco legal integral sobre IA a nivel mundial, diseñado para promover una IA confiable, que respete los derechos fundamentales, la democracia, el Estado de derecho, la sostenibilidad medioambiental; impulsando al mismo tiempo la innovación, la seguridad y los principios éticos, mientras aborda los riesgos asociados con modelos de IA de gran impacto.

Riesgos de la inteligencia artificial

La Ley de IA se enfoca en asegurar la confianza de los ciudadanos europeos en el uso de esta tecnología. Aunque muchos sistemas de IA son seguros y beneficiosos, algunos plantean riesgos que necesitan ser abordados para evitar consecuencias no deseadas. Por ejemplo, la opacidad en las decisiones de IA puede generar situaciones injustas, como en procesos de contratación o en solicitudes de beneficios públicos.

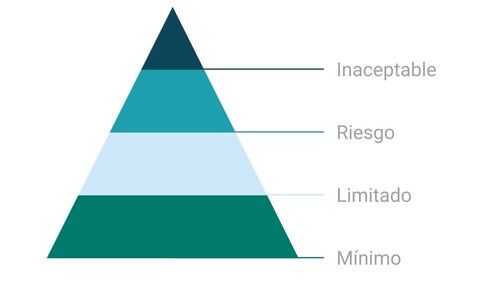

El marco regulador aprobado define cuatro niveles de riesgo para los sistemas de IA:

A partir de la entrada de vigencia de la ley, se prohibirían todos los sistemas de IA que representen una amenaza evidente para la seguridad, los medios de vida y los derechos individuales, incluyendo desde sistemas de puntuación social implementados por gobiernos hasta juguetes que utilicen asistentes de voz y promuevan comportamientos peligrosos.

Sistemas de AI de alto riesgo

Los sistemas de IA identificados como de alto riesgo incluyen la tecnología de Inteligencia Artificial utilizada en:

infraestructuras críticas (por ejemplo, el transporte), que podrían poner en peligro la vida y la salud de los ciudadanos;

formación educativa o profesional, que puede determinar el acceso a la educación y al curso profesional de la vida de una persona (por ejemplo, puntuación de los exámenes);

componentes de seguridad de los productos (por ejemplo, aplicación de IA en cirugía asistida por robot);

empleo, gestión de los trabajadores y acceso al trabajo por cuenta propia (por ejemplo, programas informáticos de selección de currículos para los procedimientos de contratación);

servicios públicos y privados esenciales (por ejemplo, calificación crediticia que deniegue a los ciudadanos la oportunidad de obtener un préstamo);

aplicación de la ley que pueda interferir con los derechos fundamentales de las personas (por ejemplo, evaluación de la fiabilidad de las pruebas);

gestión de la migración, el asilo y el control fronterizo (por ejemplo, examen automatizado de las solicitudes de visado);

administración de justicia y procesos democráticos (por ejemplo, soluciones de IA para buscar decisiones judiciales).

Los sistemas de IA de alto riesgo estarán sujetos a obligaciones estrictas antes de que puedan comercializarse. Todos los sistemas de identificación biométrica remota se consideran de alto riesgo y están sujetos a requisitos estrictos. El uso de la identificación biométrica remota en espacios de acceso público con fines policiales está, en principio, prohibido.

Las excepciones limitadas están estrictamente definidas y reguladas, como cuando sea necesario para buscar a un niño desaparecido, prevenir una amenaza terrorista específica e inminente o detectar, localizar, identificar o enjuiciar a un autor o sospechoso de un delito grave. Estos usos están sujetos a la autorización de un órgano judicial u otro órgano independiente y a límites apropiados en el tiempo, el alcance geográfico y las bases de datos consultadas.

Sistemas de AI de riesgo limitado

El riesgo limitado se reduce a los riesgos asociados con la falta de transparencia en el uso de la IA. La Ley de IA introduce obligaciones específicas de transparencia para garantizar que los seres humanos estén informados cuando sea necesario, fomentando la confianza. Por ejemplo, cuando se utilizan sistemas de IA como chatbots, los seres humanos deben ser conscientes de que están interactuando con una máquina para que puedan tomar una decisión informada de continuar o dar un paso atrás. Los proveedores también tendrán que asegurarse de que el contenido generado por IA sea identificable. Además, el texto generado por IA publicado con el propósito de informar al público sobre asuntos de interés público debe etiquetarse como generado artificialmente. Esto también se aplica al contenido de audio y video que constituye falsificaciones profundas.

Riesgo mínimo o nulo

La Ley de IA permite el uso libre de la IA de riesgo mínimo. Esto incluye aplicaciones como videojuegos habilitados para IA o filtros de spam. La gran mayoría de los sistemas de IA utilizados actualmente en la UE entran en esta categoría.

Una solución para el uso confiable de grandes modelos de IA

Cada vez más, los modelos de IA de propósito general se están convirtiendo en componentes de los sistemas de IA. Estos modelos pueden realizar y adaptar innumerables tareas diferentes. Si bien los modelos de IA de propósito general pueden permitir soluciones de IA mejores y más potentes, es difícil supervisar todas las capacidades.

Allí, la Ley de IA introduce obligaciones de transparencia para todos los modelos de IA de propósito general para permitir una mejor comprensión de estos modelos y obligaciones adicionales de gestión de riesgos para modelos muy capaces e impactantes. Estas obligaciones adicionales incluyen la autoevaluación y mitigación de los riesgos sistémicos, la notificación de incidentes graves, la realización de evaluaciones de ensayos y modelos, así como los requisitos de ciberseguridad.

Entrada en vigencia de la Ley

En diciembre de 2023, se alcanzó un acuerdo político entre el Parlamento Europeo y el Consejo de la UE sobre la Ley de IA. Actualmente, el texto está en proceso de aprobación y traducción oficiales. Una vez publicada en el Diario Oficial, la Ley de IA entrará en vigor 20 días después. Sin embargo, su plena aplicación tendrá lugar dos años después, con algunas excepciones: las prohibiciones comenzarán a regir después de seis meses, las normas de gobernanza y las obligaciones para los modelos de IA de propósito general se aplicarán después de 12 meses, y las regulaciones para los sistemas de IA integrados en productos regulados se implementarán después de 36 meses. Para facilitar la transición hacia este nuevo marco regulatorio, la Comisión ha lanzado el Pacto sobre IA, una iniciativa voluntaria que alienta a los desarrolladores de IA de Europa y otros países a anticiparse al cumplimiento de las obligaciones clave de la Ley de IA.